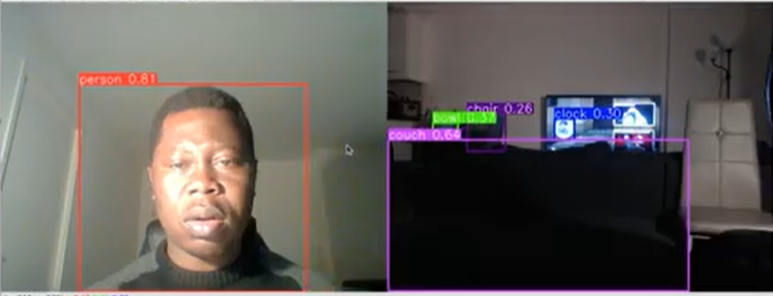

La détection d’objets en temps réel, utilisant le modèle YOLOv8 via la bibliothèque OpenCV. Ce script illustre comment YOLOv8, une évolution du populaire modèle YOLO pour la détection d’objets, peut être appliqué aux flux vidéo de deux caméras simultanément, offrant une solution puissante et flexible pour la surveillance et l’analyse vidéo en temps réel.

import cv2

from ultralytics import YOLO

# Load the YOLOv8 model

model = YOLO(‘yolov8n.pt’)

# Open the video file

video_path = “path/to/your/video/file.mp4”

cap = cv2.VideoCapture(0)

# Loop through the video frames

while cap.isOpened():

# Read a frame from the video

success, frame = cap.read()

if success:

# Run YOLOv8 inference on the frame

results = model(frame)

# Visualize the results on the frame

annotated_frame = results[0].plot()

# Display the annotated frame

cv2.imshow(“YOLOv8 Inference”, annotated_frame)

# Break the loop if ‘q’ is pressed

if cv2.waitKey(1) & 0xFF == ord(“q”):

break

else:

# Break the loop if the end of the video is reached

break

# Release the video capture object and close the display window

cap.release()

cv2.destroyAllWindows()

Related Posts